零基础入门AI:如何使用ollama本地部署DeepSeek 开源大模型

这是我的第一篇AI领域的文章,本文我将分享市面使用最多的私有化搭建AI大模型的工具(Ollama)。从如何安装、如何使用、接口文档等多种方式做一些详细的介绍。

什么是Ollama

Ollama是一个开源的本地大语言模型(LLM)运行平台,旨在让用户能够更轻松地在本地运行、管理和使用大语言模型。ollama官网下载地址

主要特点

本地运行:Ollama允许用户在本地机器上运行大语言模型,而无需依赖云端服务。这对于那些对数据隐私和安全性要求较高的用户来说非常有吸引力,因为数据不需要传输到远程服务器,减少了数据泄露的风险。本地运行还可以减少网络延迟,提高模型的响应速度,尤其在处理一些实时性要求较高的任务时表现出色。

模型管理:它提供了方便的模型管理功能,用户可以轻松地拉取(pull)、推送(push)、创建、复制和删除模型。例如,用户可以从Ollama的模型库中拉取预训练好的模型,也可以将自己训练的模型推送到模型库中与他人分享。支持多种模型格式,能够兼容不同的开源大语言模型,用户可以根据自己的需求选择合适的模型进行使用。

API支持:Ollama提供了丰富的API,方便开发者将其集成到自己的应用程序中。通过API,开发者可以调用模型进行文本生成、聊天完成、生成嵌入向量等任务。API支持流式响应,使得在处理长文本生成任务时能够实时获取生成结果,提升用户体验。

使用场景

个人开发和测试:开发者可以在本地使用Ollama来测试和开发与大语言模型相关的应用程序,无需担心云端服务的使用限制和成本问题。

企业内部应用:企业可以利用Ollama在内部部署大语言模型,用于知识管理、智能客服、自动化文档处理等场景,同时确保数据的安全性和隐私性。

教育和研究:教育机构和研究人员可以使用Ollama来进行自然语言处理相关的教学和研究工作,学生可以在本地环境中实践和探索大语言模型的应用。

如何安装

直接点击官网链接地址,根据你的操作系统选择对应的版本即可安装,支持windows系统、Mac系统和Linux三大主流系统。

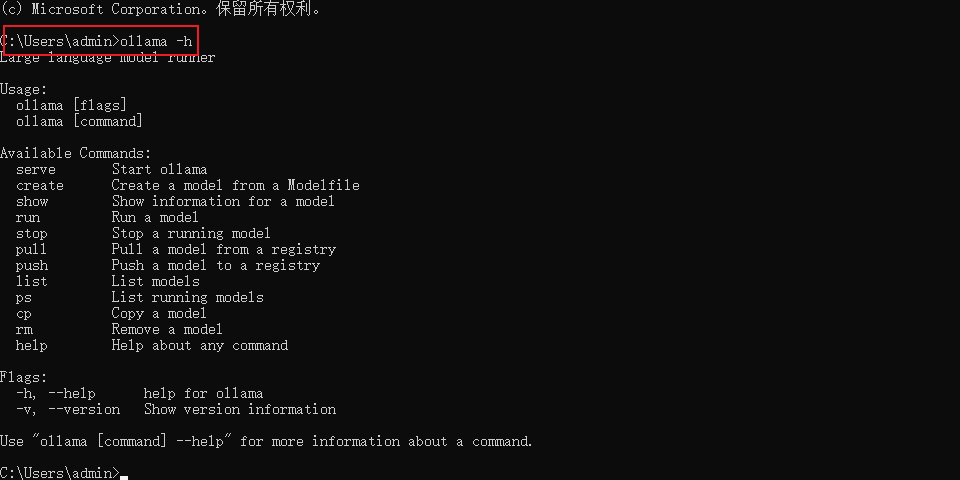

常用命令

一般我们使用ollama的原生命令可能会比较少,大多数用在基础的测试,更多的是通过API接口的方式使用,下面我罗列几个常用的命令。

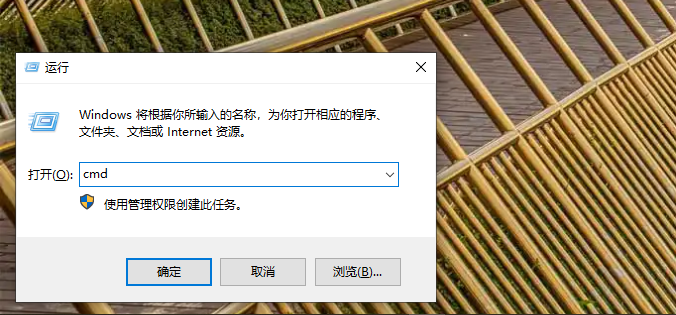

windows如何使用cmd命令。windows + R,输入cmd,然后点击确定。

- 启动ollama服务:

ollama serve

PS C:\Users\admin> ollama serve

2025/02/04 10:41:53 routes.go:1259: INFO server config env="map[CUDA_VISIBLE_DEVICES: GPU_DEVICE_ORDINAL: HIP_VISIBLE_DEVICES: HSA_OVERRIDE_GFX_VERSION: HTTPS_PROXY: HTTP_PROXY: NO_PROXY: OLLAMA_DEBUG:false OLLAMA_FLASH_ATTENTION:false OLLAMA_GPU_OVERHEAD:0 OLLAMA_HOST:http://127.0.0.1:11434 OLLAMA_INTEL_GPU:false OLLAMA_KEEP_ALIVE:5m0s OLLAMA_KV_CACHE_TYPE: OLLAMA_LLM_LIBRARY: OLLAMA_LOAD_TIMEOUT:5m0s OLLAMA_MAX_LOADED_MODELS:0 OLLAMA_MAX_QUEUE:512 OLLAMA_MODELS:C:\\Users\\admin\\.ollama\\models OLLAMA_MULTIUSER_CACHE:false OLLAMA_NOHISTORY:false OLLAMA_NOPRUNE:false OLLAMA_NUM_PARALLEL:0 OLLAMA_ORIGINS:[http://localhost https://localhost http://localhost:* https://localhost:* http://127.0.0.1 https://127.0.0.1 http://127.0.0.1:* https://127.0.0.1:* http://0.0.0.0 https://0.0.0.0 http://0.0.0.0:* https://0.0.0.0:* app://* file://* tauri://* vscode-webview://*] OLLAMA_SCHED_SPREAD:false ROCR_VISIBLE_DEVICES:]"

time=2025-02-04T10:41:53.991+08:00 level=INFO source=images.go:757 msg="total blobs: 10"

time=2025-02-04T10:41:53.992+08:00 level=INFO source=images.go:764 msg="total unused blobs removed: 0"

time=2025-02-04T10:41:53.993+08:00 level=INFO source=routes.go:1310 msg="Listening on 127.0.0.1:11434 (version 0.5.4)"

time=2025-02-04T10:41:53.994+08:00 level=INFO source=routes.go:1339 msg="Dynamic LLM libraries" runners="[rocm_avx cpu cpu_avx cpu_avx2 cuda_v11_avx cuda_v12_avx]"

time=2025-02-04T10:41:53.994+08:00 level=INFO source=gpu.go:226 msg="looking for compatible GPUs"

time=2025-02-04T10:41:53.994+08:00 level=INFO source=gpu_windows.go:167 msg=packages count=1

time=2025-02-04T10:41:53.994+08:00 level=INFO source=gpu_windows.go:214 msg="" package=0 cores=4 efficiency=0 threads=8

time=2025-02-04T10:41:54.008+08:00 level=INFO source=gpu.go:392 msg="no compatible GPUs were discovered"

time=2025-02-04T10:41:54.008+08:00 level=INFO source=types.go:131 msg="inference compute" id=0 library=cpu variant=avx2 compute="" driver=0.0 name="" total="15.9 GiB" available="6.9 GiB"- 查看模型列表:

ollama list

PS C:\Users\admin> ollama list

NAME ID SIZE MODIFIED

deepseek-r1:7b 0a8c26691023 4.7 GB 23 hours ago

qwen:4b d53d04290064 2.3 GB 6 weeks ago- 运行模型:

ollama run <model>

PS C:\Users\admin> ollama run qwen:4b如果本地没有该模型,模型会自动从ollama的模型库中拉取。